AI & ART - Kan een robot kunst maken?

“AI-Generated Art Scene Explodes as Hackers Create Groundbreaking New Tools” (Vice) – Een meer gepaste inleiding kon deze post niet hebben, want dat is exact wat we in dit educatief AI-project zullen doen: kunst maken met artificiële intelligentie. Niet door ingewikkelde technieken en berekeningen, maar door een simpele zin in te toetsen. Ontketen jouw lyrische Picasso in ‘AI & ART – DALL-E’s Workshop’!

Beschouwen

Zelf heb ik een bescheiden voorgeschiedenis als leerkracht Plastische Opvoeding (vorig jaar Beeld, nu veelal geïntegreerd). De opbouw beschouwen, creëren en reflecteren heb ik even geleend uit dat leerplan. Tijd dus om het artistiek werk van deze neurale netwerken, want we gebruiken er maar liefst vijf in dit project, te ‘beschouwen’.

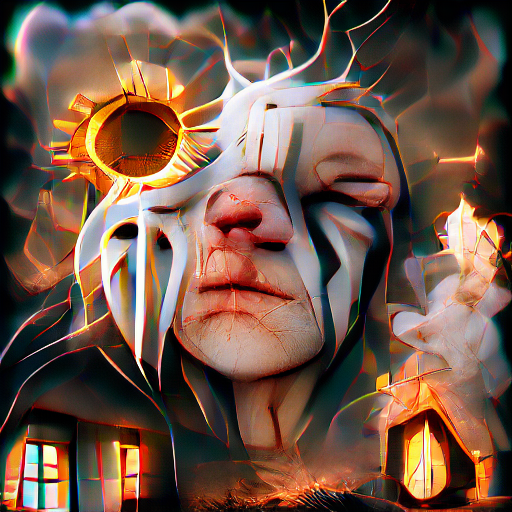

Zoals je merkt, zijn deze creaties best maf, gek of lijken te komen uit een vreemde nachtmerrie. Die analogie is zo gek nog niet, want deze creaties tonen gelijkenissen met het DeepDream-project van Google. Daarbij was het mogelijk om, via Google’s voorgetrainde neurale netwerken, te kijken naar hoe een AI ‘droomt’. Dit werd gedaan door gekozen afbeeldingen doorheen de verschillende neurale netwerken te halen. De ene was specifiek getraind op- en ging op zoek naar figuren van katten, de volgende auto’s … waarbij ze telkens de afbeelding aanpasten om meer katten of auto’s te zien. Dit vond plaats in ‘latent space’, of de ‘geheime ruimte’ tussen de verschillende delen van de AI.

In dit AI-project maken we ook gebruik van die ‘latent space’, maar met enkele belangrijke wijzigingen. Zo maken we geen gebruik van de AI netwerken van Google, maar van CLIP en VQGAN. CLIP is een ‘text-to-image’ technologie en maakt het mogelijk voor ons om met één zin onze AI aan het werk te zetten. VQGAN aan de andere zijde werkt volgens het principe van een ‘Generative Adversial Network’ (GAN), waarbij twee systemen het tegen elkaar opnemen. Een generator en een discriminator. De generator zal afbeeldingen genereren op basis van ons commando. De discriminator zal die afbeelding bekijken en oordelen of die wel voldoende lijkt op ons commando. Dat doen die twee systemen opnieuw, opnieuw, opnieuw … tot we, na vele iteraties, ons gewenst resultaat bereiken.

Dat is niet het enige verschil met DeepDream. Niet alleen gebruiken andere AI-modellen, deze zijn ook niet-voorgetraind! Waarbij we bij andere projecten werken met voorgeclassificeerde afbeeldingen, een model trainen op muziek of fine-tunen op de boeken van Harry Potter, taken die uren in beslag kunnen nemen, zijn de modellen in dit deel niet voorgetraind. We volgen een zero-shot aanpak. Zero training.

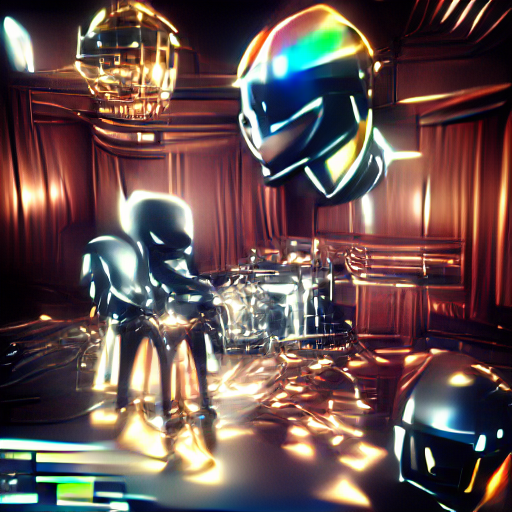

Daarna animeren we onze creaties met nog eens drie neurale netwerken. Zo maken we van ons 2D-prent een 3D-beleving. Dit doen we door 3D Inpainting. Een best ingewikkelde taak, want dat betekent dat we de delen die niet te zien zijn op de 2D-weergave, moeten inschatten met een AI. We gebruiken hiervoor een neuraal netwerk dat getraind is om randen te herkennen, een netwerk om in te kleuren en een netwerk om de diepte te berekenen. Eenmaal klaar komt onze prent tot leven!

Creëren

Om aan de slag te gaan heb je enkel een goede zin nodig als commando. Daarnaast een computer en een Chrome-browser. Meer niet! Voorkennis van Python en AI is handig, maar zeker niet vereist.

Reflecteren

Na enkele maanden te hebben geëxperimenteerd met deze CLIP+VQGAN aanpak, vallen er toch enkele zaken op.

1) Het is perfect mogelijk om een goed resultaat te bekomen met enkele pogingen.

2) Het is ook mogelijk dat je, na 3.000 steps, nog steeds niet tevreden bent. Het systeem is weinig voorspelbaar en meerdere iteraties staan niet per se gelijk aan betere kwaliteit.

3) Het systeem dat aan de slag gaat met onze tekstcommando’s kan gemanipuleerd worden door specifieke trefwoorden. Zoals “in the style of Van Gogh”, “in the style of Ghibli” … zo slagen we erin om aan ‘style transfer’ te doen. Dit wil zeggen dat ons AI-kunstwerk eigenschappen van een bepaalde kunstenaar of kunstwerk overneemt!

4) Maar ook meer ongewone trefwoorden, zoals “unreal engine”, “Free HD Wallpaper”, “in the style of a 100.000 dollar NFT”, “Ultra High Settings”. Dit zijn eerder trefwoorden die je zou verwachten bij een zoekmachine zoals Google. Toch slagen we er in om zo betere kwaliteit te bereiken (hoewel ook deze trefwoorden hun eigen artefacten kunnen veroorzaken, zoals een UE-kenteken bij gebruik van “unreal engine”).

Experimenten zoals deze met DALL-E zijn ideaal om aan de slag te gaan met AI en deze vorm van ‘kunst’ te democratiseren. Met minimale voorkennis en slechts één tekstcommando tover je waanzinnige zaken op het scherm.

Vragen, opmerkingen?

Vragen of opmerkingen over dit project of een van mijn andere projecten? Dan kan je hieronder terecht!